Смысловые галлюцинации: как нейросети сначала захватили интернет, а потом превратили его в цирк

Что будет, если весь интернет заполонит контент от ИИ? Или он уже это сделал? Разбираемся, как нейросети прошли путь от забавных картинок до горящей Эйфелевой башни, — и пытаемся понять, что нам теперь с этим делать.

Уилл Смит ест спагетти (и пугает весь интернет)

В 2021 году все внезапно заговорили о нейросетях. Это не значит, что раньше ими никто не занимался, — просто эта технология разрабатывалась не для общего пользования. Все изменилось, когда стали доступны ChatGPT и MidJourney.

Самым ярким мемом того периода стал Уилл Смит, который ест спагетти. Пользователи задали нейросети простой запрос — нарисовать, как актер поедает пасту. Итог получился такой забавный и даже жуткий, что моментально завирусился в интернете. Мы еще к нему вернемся.

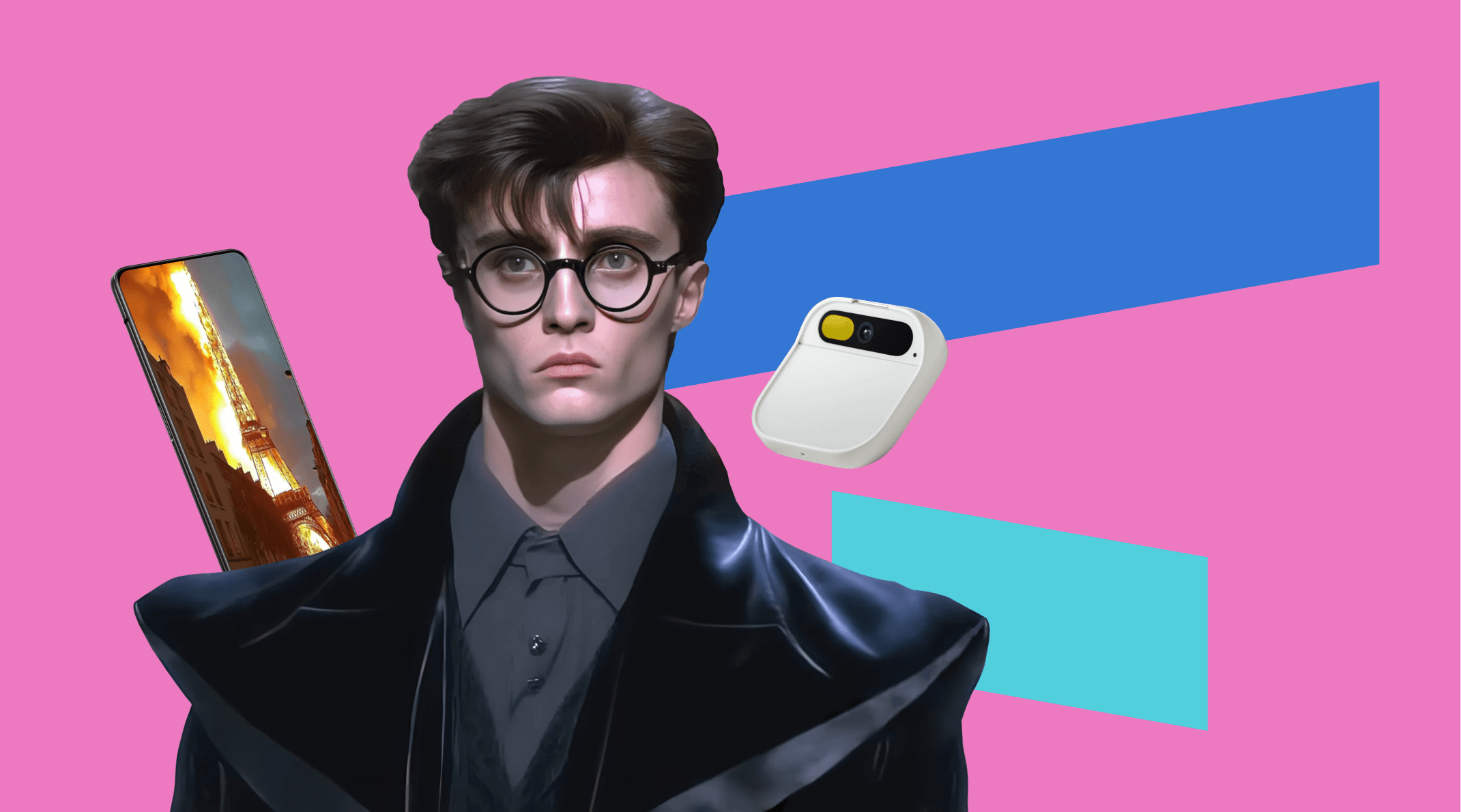

Веселье продолжалось, и люди начали переделывать известные франшизы под модные тренды. Самый знаменитый из таких экспериментов — Гарри Поттер, которого переместили в мир модного дома Balenciaga. Постепенно тренд стал очень популярным: люди переделывали «Властелина Колец», «Во все тяжкие», «Голодные игры» и многое другое.

Но не все было так безобидно. Одна из самых странных галлюцинаций, которые когда-либо происходили с нейросетями, случилась у сервиса «Балабоба» от «Яндекса». Компания запустила бесплатную нейросеть в 2021 году с очень простым принципом: пользователь вводил начало фразы или первое предложение, а нейросеть дописывала остальной текст в разных стилях («репортаж», «новости», «слухи» и так далее). Веселый сервис, который помогал писать простые тексты и умел шутить. Что могло пойти не так?

Примерно все. Первая версия «Балабобы» генерировала грубые и даже экстремистские тексты. Она могла оскорбить пользователя, выдать абсолютный бред за факты и вообще не заботилась об этичности того, что генерирует. «Яндексу» пришлось на время выключить сервис и вручную его дорабатывать. Вторая версия была уже гораздо безобиднее и доступна даже сейчас.

Когда смех закончился

Нейросети очень быстро развиваются. Примерно через 1,5−2 года после выхода легендарного видео с Уиллом Смитом вышла новая версия, которая уже не выглядела смешно. Скорее реалистично, если не присматриваться к деталям. А если этого не делать, то действительно можно подумать, что на видео реальный человек и реальные спагетти.

С текстами ситуация тоже улучшилась. Сейчас сгенерированные публикации заполонили интернет, вытесняя реальных людей с рынка копирайтеров. В 2024 году каждая большая корпорация внедрила нейросети в свои устройства: Apple добавила текстовую модель в свои компьютеры, чтобы вы могли поручить роботу написание писем. Google со своим Gemini пытается переизобрести то, как мы пользуемся поиском в интернете. А сама компания OpenAI заключает сделки с ведущими мировыми СМИ — так что скоро нейросети проберутся и в журналистику.

Здорово? Не уверены. Еще до всемирной популярности технология нейросетей подвергалась критике. Дело не только в страхе перед тем, что нас захватят злые роботы.

В 2018 году прогремели скандалы о расовой предвзятости ИИ — алгоритмы учились в основном на фотографиях белых людей и не распознавали пользователей с другим цветом кожи. Чем дальше развивались нейросети и чем лучше они становились, тем больше вопросов к ним появлялось. Если сегодня нейросеть может нарисовать относительно реалистичного Уилла Смита, то скоро она может и подделывать новости и фотографии.

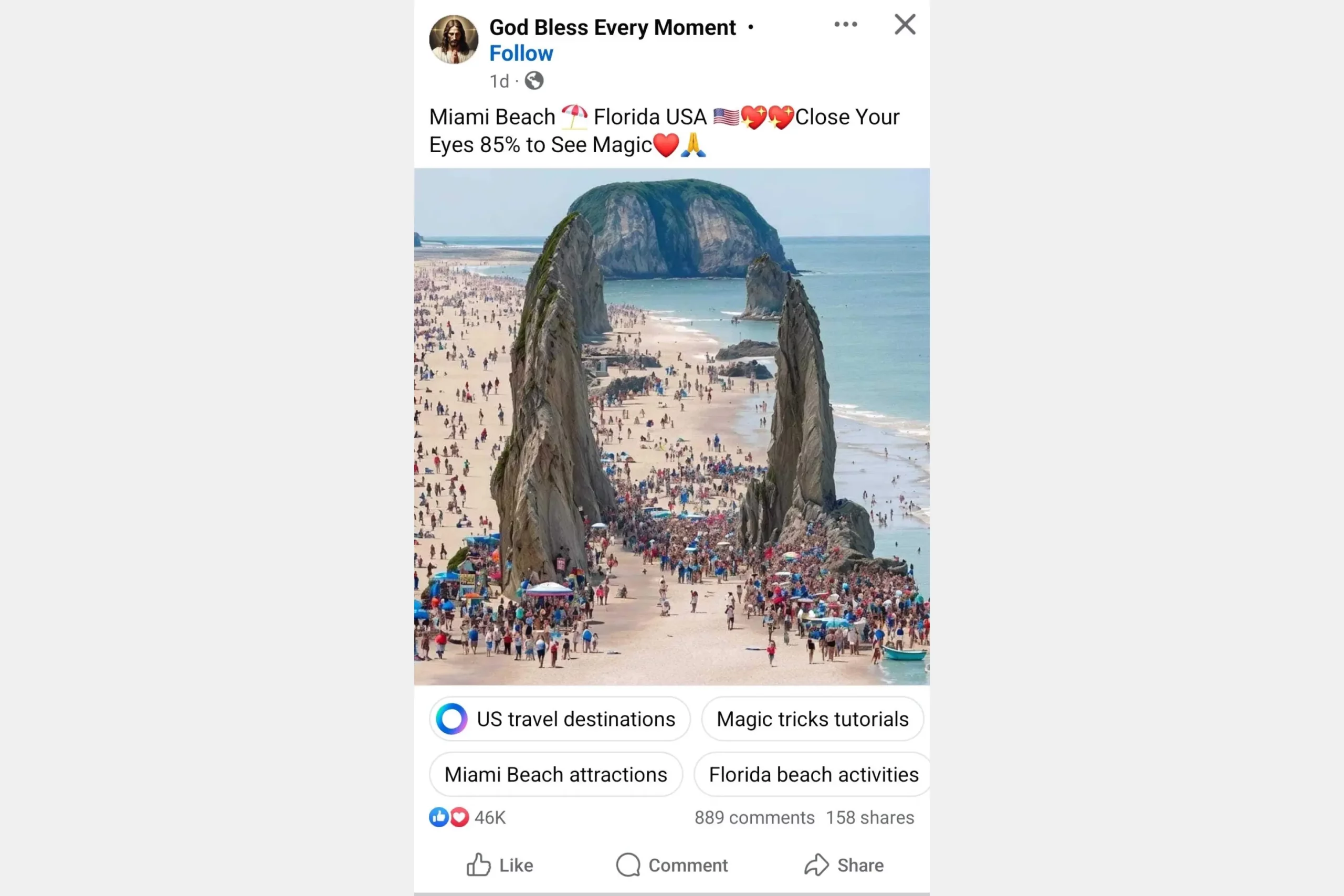

В 2023 году на полчаса тысячи людей поверили, что Эйфелева башня загорелась. Эксперты быстро провели факт-чек и выяснили, что изображение сделали с помощью MidJourney. Основная аудитория таких фейков — это люди старшего поколения (50+), им сложнее различать контент от робота и от человека. В социальных сетях есть целые группы, которые постят сгенерированные картинки под видом реальных фотографий и новостей.

Галерея

Через какое-то время мошенники смекнули, что это золотая жила — и тогда с помощью технологий Deep Fake (когда у пользователя меняется в реальном времени лицо и голос) начали выманивать у людей деньги. В основном жертвами мошенников становились пенсионеры. Проблема стала настолько серьезной, что банкам пришлось выпускать инструкции, как отличить дипфейк от реального человека.

Когда обманывает не человек, а робот

Здесь можно привести аргумент, что люди сами используют великолепную технологию в плохих целях. И в целом это правда, хотя ИИ пока не является надежным инструментом. Кембриджский словарь назвал слово «галлюцинировать» (hallucinate) словом 2023 года. Это термин для описания ситуации, когда искусственный интеллект генерирует неточную, неверную или полностью выдуманную информацию. Ошибки могут проявляться в разных формах — от смешных и абсурдных картинок до полноценной дезинформации. Особенно это актуально для языковых моделей типа GPT, которые создают текст на основе массива открытых данных.

Галлюцинации происходят по нескольким причинам:

1. Ограниченность данных. ИИ обучается на массивах открытых данных, которые часто содержат в себе неточности. Нейросеть просто обрабатывает такие ошибки и бездумно добавляет их в свои цепочки ответов. Особенно сильно от этого страдает Gemini, нейросеть от Google, которая обучается на очень разнородной информации, в том числе на постах из Reddit.

2. Актуальность данных. Помимо ошибок, данные могут банально устареть. Нейросеть берет те данные, до которых может дотянуться. Особенно это актуально для данных из медицины — многие исследования публикуются в закрытых журналах с подпиской, к которым у нейросети нет доступа. Поэтому ей приходится давать ответ на основе старых и непроверенных источников.

3. Обобщение информации. Даже если источники, которые берет нейросеть, содержат в себе только проверенную информацию, в своих ответах модель часто обобщает ее. Если модель сталкивается с ситуацией или вопросом, по которому у нее недостаточно данных или нет ясного контекста, она может предоставить ответ, основываясь на наиболее вероятных, но ошибочных паттернах.

4. Непонимание контекста. ИИ не обладает истинным пониманием контекста или смысла. Нейросеть оперирует на основе шаблонов и статистики, а не на основе глубокого понимания предмета. Поэтому он может создавать ответы, которые кажутся логичными, но фактически являются ошибочными.

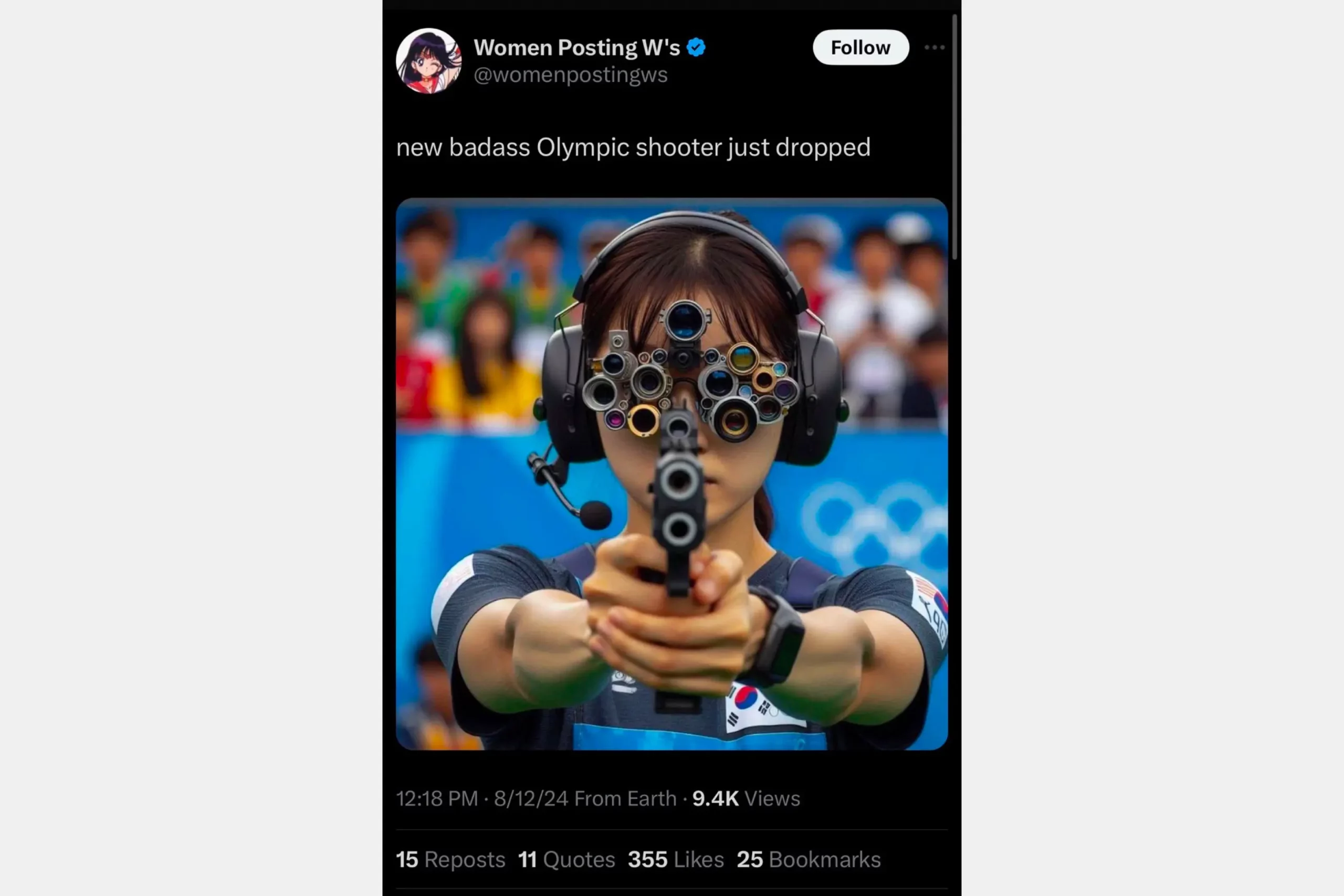

Галлюцинации — это важная проблема, которую еще предстоит изучить. Пока что нет четкого ответа, как можно поправить эту проблему. При этом постепенно появляются устройства, которые работают исключительно через нейронные модели (AI Pin или Rabbit R1). Создатели этих устройств хотят заменить смартфоны и перенести нас в «будущее ИИ». Но страшно представить, что будет, если вы заблудитесь с таким гаджетом в незнакомом городе, попробуете что-то заказать в доставке еды или вызовете такси. Скорее всего, все пойдет не так.

Как защититься от «галлюцинаций» и фейков

Перепроверяйте всю информацию, которую вам выдает нейросеть. Запрашивайте у нее источники, по которым она написала вам ответ, и смотрите на даты их публикаций.

Посмотрите, есть ли то, о чем написала нейросеть, внутри самих статей. Возможно, она как-то неправильно проинтерпретировала данные или не так расставила акценты. Попросите ИИ подредактировать ответ с учетом ваших замечаний. Или, что будет даже лучше, допишите текст самостоятельно.

Также есть несколько сервисов, которые помогут вам отличить сгенерированный нейросетью контент от созданного человеком. Вот несколько из тех, которые можно использовать:

1. GPTZero — проверяет текст на следы нейросетей. Если кто-то написал вам работу или статью через ChatGPT, сервис это сразу поймет. Программа отслеживает «плавность» текста, которая не свойственна роботу.

2. Turnitin — сервис для проверки плагиата. Обычно его используют в академической среде, поэтому он довольно мудреный. В сервисе есть функция по определению контента, сгенерированного ИИ.

3. FotoForensics (не работает в РФ) — сервис, который помогает определить, не сгенерировал ли кто-то фотографию или картинку.

С помощью инструментов и собственной внимательности вы всегда сможете проверить контент на достоверность. ИИ за последние пару лет очень сильно прибавил в качестве, но у него по-прежнему плохо получаются детали на заднем плане фото и глаза людей. А в текстах он часто прибегает к штампованным формулировкам. Будьте внимательны.

Понравилась статья?

Теги статьи

Нам нравится, что вам нравится

Уверены, вы можете не хуже! Напишите статью и получите Бонусы.

Спасибо, что вам есть что сказать

Попробуйте расширить свою мысль и написать статью — и получите за это Бонусы.

Комментарии

Авторизуйтесь, чтобы иметь возможность писать комментарии:

Войти